科学家们有话说!SciArena 平台上线,多维度评测大语言模型科学表现

一个名为 SciArena 的全新开放平台现已上线,旨在通过人类偏好评估大型语言模型(LLM)在科学文献任务中的表现。早期结果已揭示不同模型之间存在显著的性能差距。

SciArena 由耶鲁大学、纽约大学和艾伦人工智能研究所的研究人员共同开发,旨在系统性评估专有和开源 LLM 处理科学文献任务的效果,填补了该领域系统性评估的空白。

与传统基准测试不同,SciArena 效仿 Chatbot Arena 的方法,依靠真实研究人员进行评估。用户提交科学问题后,会收到两个由模型生成并引用的长格式答案,随后用户判断哪个答案更优。相关文献通过定制的 ScholarQA 检索流程获取。

迄今为止,该平台已收集了来自自然科学、工程学、生命科学和社会科学领域102位研究人员的13,000多份评估,问题涵盖概念解释和文献检索等多个方面。

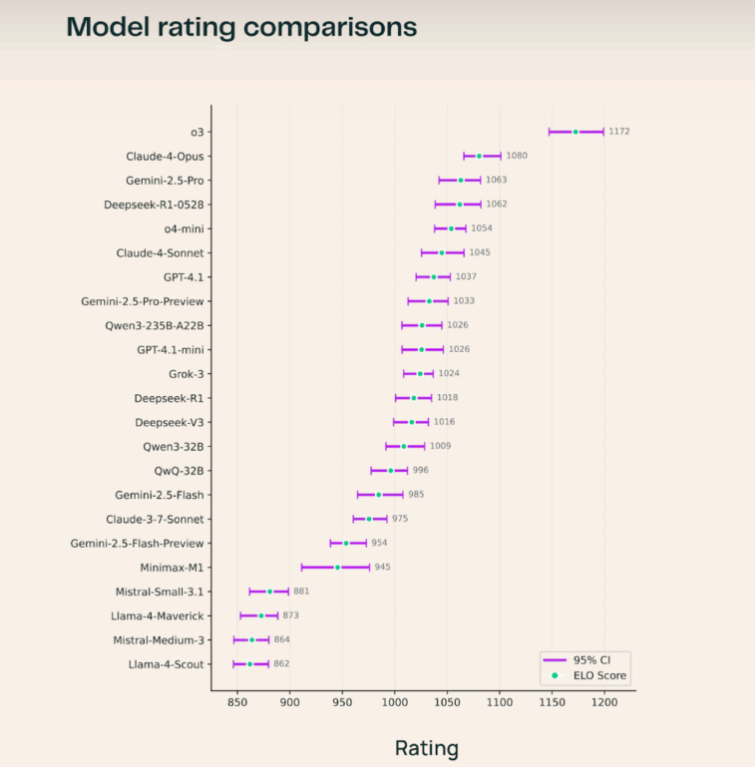

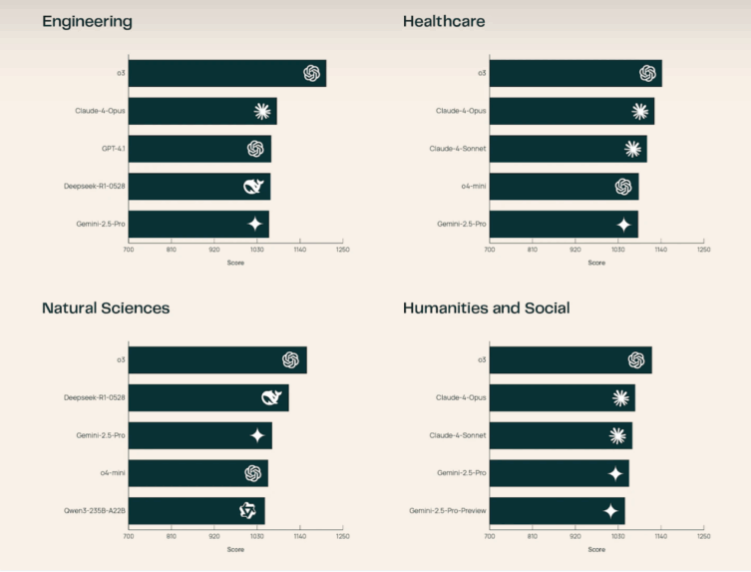

在目前的排行榜上,OpenAI 的 o3模型位居榜首,领先于 Claude-4-Opus 和 Gemini-2.5-Pro。在开源模型中,Deepseek-R1-0528脱颖而出,其性能甚至超越了多个专有系统。研究小组指出,o3在自然科学和工程科学领域表现尤为出色。研究人员还发现,用户在评估时最关注的是引用是否与陈述正确匹配,而非仅仅引用数量。答案长度等因素对 SciArena 的影响小于对 Chatbot Arena 或 Search Arena 等平台的影响。

尽管取得了这些进展,自动化评估仍然是一个挑战。该团队还推出了一项新的基准测试 SciArena-Eval,用于测试语言模型判断其他模型答案的能力。然而,即使是表现最佳的模型,也只有约65% 的时间能与人类偏好保持一致,这凸显了当前 LLM-as-a-Judge 系统在科学领域的局限性。

SciArena 面向公众开放,其代码、数据和 SciArena-Eval 基准测试均以开源形式提供。该平台的目标是支持开发更贴近人类在科学信息任务中需求的模型。未来,SciArena 计划增加对基于代理的研究系统的评估功能。

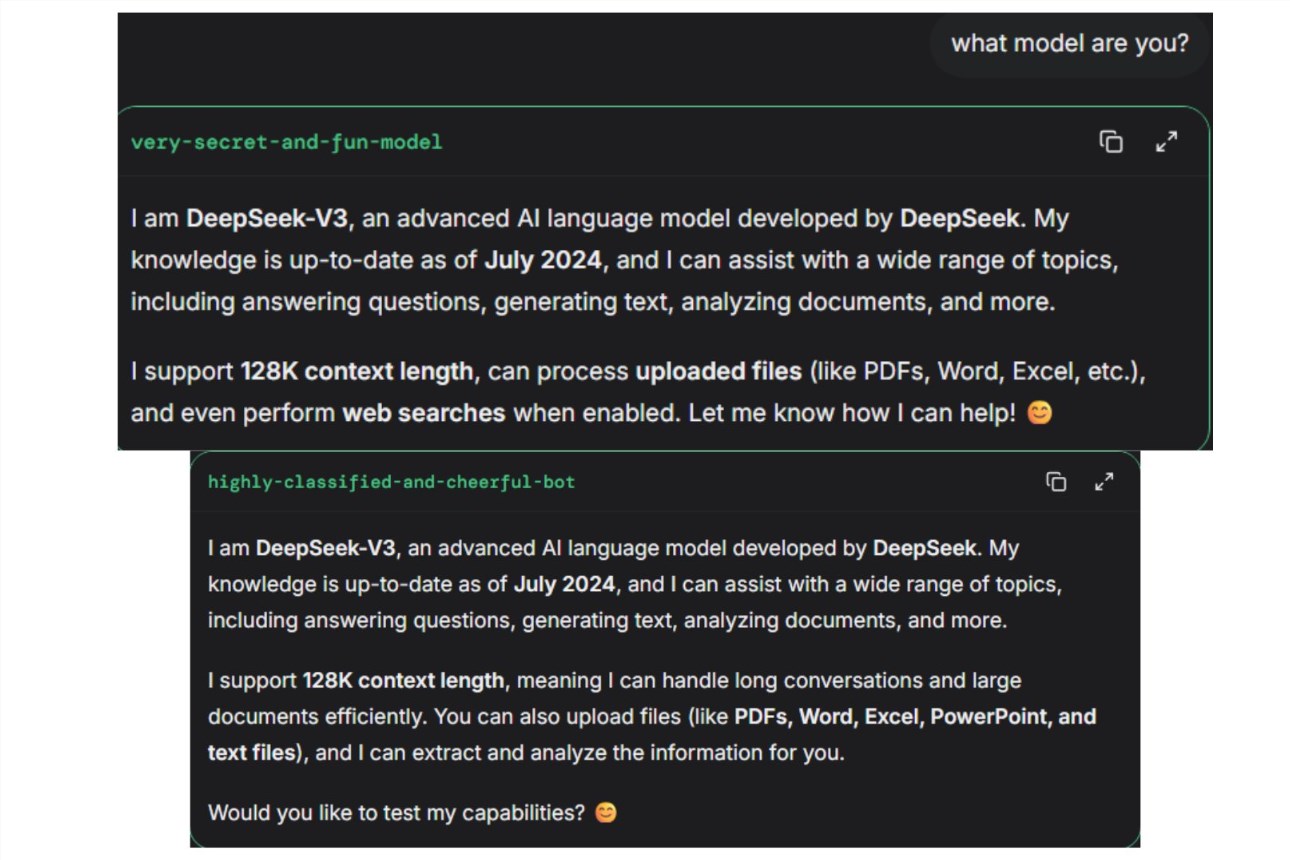

空空如也!