混元世界模型1.1正式发布:革新3D 重建技术,秒级生成高质量场景

今日,腾讯正式发布并开源了混元世界模型1.1(WorldMirror),这一全新版本在多视图和视频输入支持、单卡部署以及生成速度等方面进行了重大升级,为3D 重建技术的普及和应用打开了新的大门。

混元世界模型1.1以其强大的功能,致力于将专业的3D 重建技术变为普通用户可轻松使用的工具。该模型能够在仅仅数秒内,从视频或图片中生成专业级的3D 场景,大幅提升了3D 重建的效率和便捷性。其前身混元世界模型1.0于今年7月发布,成为业界首个兼容传统 CG 管线的开源可漫游世界生成模型,而新版本则在此基础上实现了多模态先验注入和多任务统一输出的端到端3D 重建。

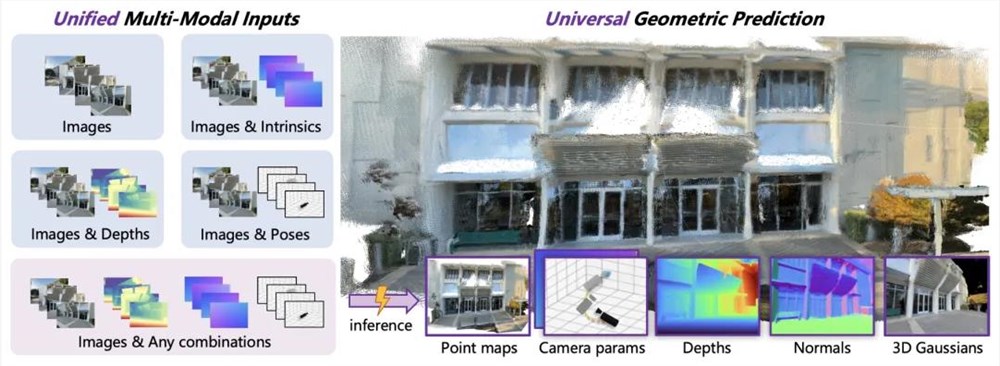

该模型的三个主要特性包括灵活处理不同输入、通用3D 视觉预测和单卡部署秒级推理。混元世界模型1.1采用了多模态先验引导机制,支持相机位姿、相机内参和深度图等多种信息的注入,确保生成的3D 场景在几何上更加准确。同时,该模型实现了点云、深度图、相机参数、表面法线和新视角合成等多种3D 几何预测,展示出显著的性能优势。

与传统的3D 重建方法相比,混元世界模型1.1利用纯前馈架构,能够在单次正向传播中直接输出所有3D 属性,显著降低了处理时间。对于典型的8-32视图输入,模型仅需1秒钟即可完成推理,满足了实时应用的需求。

在技术架构方面,混元世界模型1.1采用多模态先验提示和通用几何预测架构,结合课程学习策略,使得模型在复杂的真实环境中保持高效、准确的解析能力。通过动态注入机制,模型能够灵活应对各种先验信息,提升了3D 结构的一致性和重建质量。

目前,混元世界模型1.1已经在 GitHub 上开源,开发者可以轻松克隆仓库并进行本地部署。同时,普通用户也可以通过 HuggingFace Space 在线体验,上传多视图图像或视频,实时预览生成的3D 场景。该技术的发布标志着3D 重建领域的一次重要进步,未来将进一步推动虚拟现实、游戏开发等多个行业的发展。

-

项目主页:https://ift.tt/8Upv5Hu

-

Github 项目地址:https://ift.tt/QNEPRtu

-

Hugging Face 模型地址:https://ift.tt/0f8GPJc

空空如也!